在本地部署使用llama 3.1并设置远程使用的简单方法

前言:

Llama 3.1 是 Meta(Facebook 的母公司)发布的一系列最先进的开源大语言模型。Llama 3.1 系列包括 8B(80 亿参数)、70B(700 亿参数)和 405B(4050 亿参数)模型。其中,405B 是 Meta 迄今为止最大的模型。

本地部署的硬件要求,请确认您的硬件是否能够正常运行,以免浪费时间

Windows:3060以上显卡+8G以上显存+16G内存,硬盘空间至少20G

Mac:M1或M2芯片 16G内存,20G以上硬盘空间

具体模型的显卡需求:

- llama3.1-8b,至少需要8G的显存

- llama3.1-70b,至少需要大约 70-75 GB 显存

- llama3.1-405b,运行需要非常高的显存和硬件资源,至少需要大约 400-450 GB 显存,请谨慎选择。

如果确定没问题,请继续往下看。

一、下载Ollama

Ollama 是一个开源的大模型管理工具,它提供了丰富的功能,包括模型的训练、部署、监控等。通过Ollama,你可以轻松地管理本地的大模型,提高模型的训练速度和部署效率。此外,Ollama还支持多种机器学习框架,如TensorFlow、PyTorch等,使得你可以根据自己的需求选择合适的框架进行模型的训练。【官网下载地址】请根据您的系统下载对应的版本

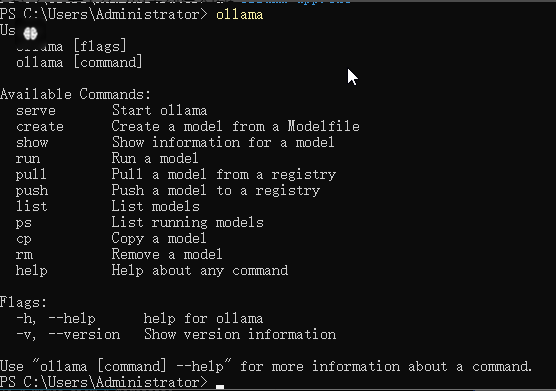

二、安装使用Ollama

双击安装,默认安装在C盘。安装完成后打开 windows powershell 或 CMD 命令行终端,输入 ollama 命令,回车,即可显示 ollama 命令的使用帮助

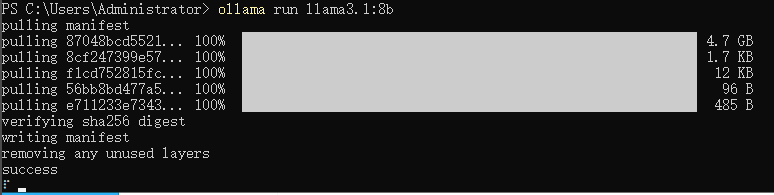

三、下载llama 3.1模型文件

运行CMD命令,输入

ollama run llama3.1:8b如果你的硬件强悍,显卡非常好,也下载更大的llama 3.1的模型70B和405B

ollama run llama3.1:70b

ollama run llama3.1:405b耐心等待下载加载完成后就可以对话测试看看有没有问题。

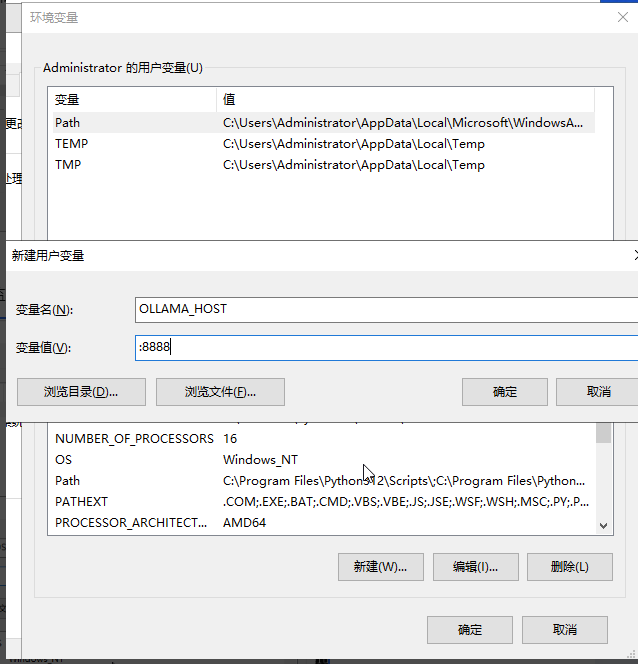

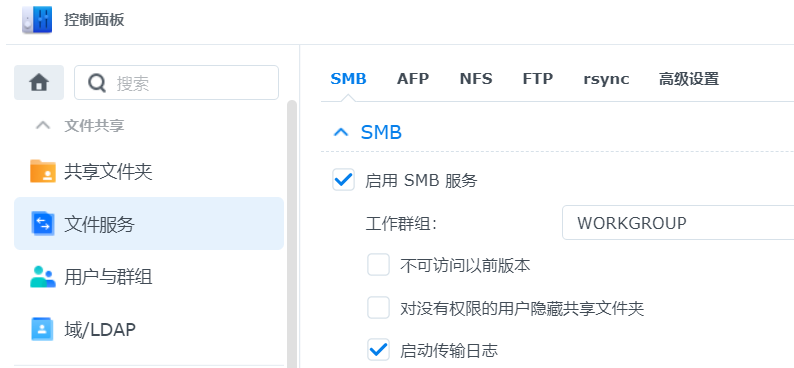

四、配置远程访问

Ollama 启动的默认地址为http://127.0.0.1:11434,我们需要远程调用,可以通过设置环境变量 OLLAMA_HOST来修改默认监听地址和端口

三个变量的用途

| 变量名 | 值 | 说明 |

| OLLAMA_HOST | 0.0.0.0:8888 | 用于配置监听的 IP 和端口 |

| OLLAMA_ORIGINS | * | 支持跨域访问,也可以指定特定域名,如:”baidu.com,hello.com” |

| OLLAMA_MODELS | C:\Users\Administrator\.ollama | 模型文件较大,建议调整到数据盘目录下。 |

windows 修改环境变量的方法:

1、停止和退出ollama 服务

2、右键”此电脑 > 属性 > 高级系统设置 > 环境变量 > Administrator 的用户变量 > 新建用户变量”,把3个变量依次添加进去

3、然后重新启动 ollama 服务并加载模型

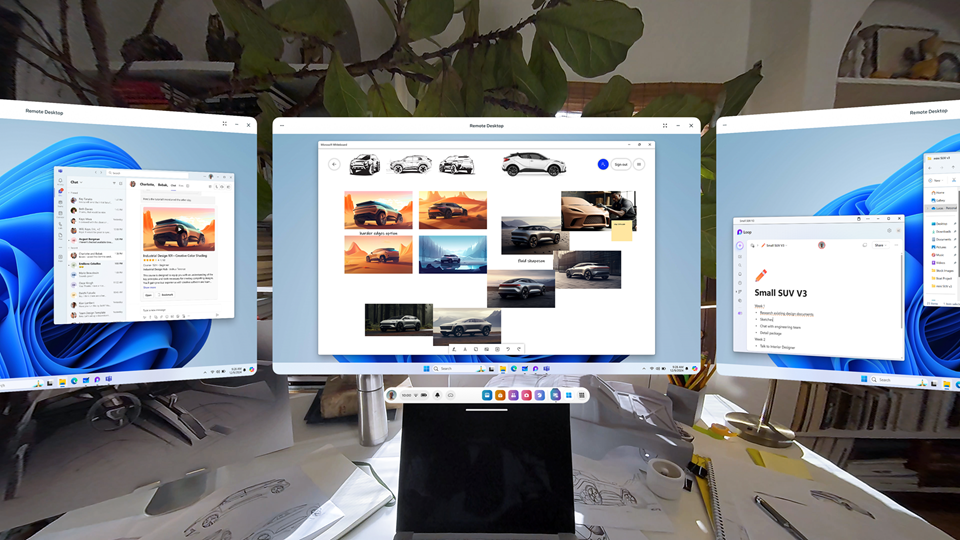

4、接下来我们就可以使用可视化的Web UI来远程使用了,这类UI有很多,推荐2款,之前有过介绍和官方都有详尽的文档,就不多说了,请参照官方文档。

Open WebUI

LobeChat

结语:

好了,本篇文章到此结束。写起来密密麻麻,做起来其实很简单,希望对大家有所帮助。

Comments